RTSP/RTPでマルチクライアント対応マルチキャストストリーミング

RTSP/RTPでマルチクライアント対応マルチキャストストリーミング

RTSP/RTPでマルチクライアント対応マルチキャストストリーミング

自作の見守りカメラや定点カメラ、監視・防犯カメラ構想において1クライアント1画面への配信なら残すは設置のみかと思ったものの、複数デバイスで同時に映像確認できた方が...と思うに至ってみれば、以前、RTSP/RTPに触れる機会があったこともあってRTPでLAN内の複数クライアントと併せ、同一クライアント内のVLCやffplayにも同時配信してみた話。

尚、ここでは、video(映像)のみの配信であり、audio(音声)については考慮していません。

音声については別件でBluetoothイヤホンのマイクを認識させるべく、PulseAudioから移行したPipeWireにおいて何れでも違和感1つなく使えたMurmur/Mumbleで実装してみようかなとか。

- 必要なハードウェア

- 必要なソフトウェア

- DebianにおけるVLCでのRTSP/RTP対応

- VLCによるRTPストリーミング事前設定

- VLC(GUI)でRTSP/RTP配信・受信方法一例

- cvlc(CLI)でRTSP/RTP配信・受信方法一例

- WiresharkでRTPストリームをキャプチャ

- 故障かな?と思ったら...

必要なハードウェア

ハードウェアと言っても要は複数台のパソコンやスマホとネットワークカメラ|IPカメラ。

今回使ったパソコンとスマホは以下の通り。

- Raspberry Pi 400/Raspberry Pi OS bullseye

- dynabook B45/B/Debian 12 Bookworm

- Motorola moto G8 Power Lite/Android 10

今回、IPカメラとして使ってみたのは、次の通り。

- Freenove技適済みカメラ付きESP32-S3-WROOM-1開発ボード(技適対応)

- ESP32 WROVER E + OV2460カメラ(技適なし)

- ESP32-CAM(技適なし)

と言ってもESP32-S3は本番用として検証では、他の2ボードにArduino IDEでRTSP配信のみに特化したスケッチESP32-CAM_RTSPを拝借、アップロードしたものを使用。

Wi-FiのSSIDとPASSPHRASE、LAN内での固定IPアドレスは、src/wifi_config.hを修正・追記。

また、Arduino IDEで使うにあたっては、格納ディレクトリ名と.inoファイル名を一致させておきます。

尤も、そうでない場合でも、.inoファイルを開く際に注意されつつ、その時点でも作成できますが。

尚、当該スケッチを使うに当たり、注意事項が2点。

まず、1点めは、Arduino IDEの[ファイル] => [環境設定]で[コンパイラの警告]を[初期値]( or [なし])に設定すること。

そうしないと、少なくとも、これが[全て]となっていると[src/CRtspSession.cpp]ファイルの287行目付近のsnprintf関数でエラーとなり、ことごとく文字列項目を外さないと通らず、かと言って、そうすると肝心なRTSP配信できなくなるので。

2点めは、WROVER-Eチップが載ったOV2640カメラボードについては、スケッチに当該ボードのカメラ用ピンアサインなどの情報がないため、要追記。

具体的には、[src/OV2640.cpp]ファイルにおいて[camera_config_t esp32cam_wrover_kit_config{}]などとしてArduino IDEのESP32サンプルスケッチCameraWebServerのcamera_pins.hの[CAMERA_MODEL_WROVER_KIT]を参照するなどして設定値群を追記。

そしてOV2640.hの[extern camera_config_t]行末尾にでもカンマに続けてconfig名を追記。

また、これに伴い、.inoファイルの37行め付近の[esp_err_t err = cam.init();]の()内は同名の*_configを設定し、一致させること。

更にWROVER-Eチップ+OV2640カメラボードのArduino IDEにおけるボード設定は[ESP32 Wrover Module]ではなく、[ESP32 Wrover Kit(all versions)]にし、PSRAMを[Enabled]、[Partition Scheme]を[Huge APP 3MB No OTA/1MB SPIFFS]に設定すること。

他方、ESP32-CAMの場合は、スケッチ既存の[esp32cam_aithinker_config]、ボードには[AI Thinker ESP32-CAM]、[Partition Scheme]には、[Huge APP 3MB No OTA/1MB SPIFFS]を設定。

また、ESP32-S3カメラボードの場合は、Arduino IDEでFreenoveのスケッチ等もしくは、それらを見るにESP32サンプルスケッチCameraWebServerのcamera_pins.hの[CAMERA_MODEL_ESP32S3_EYE]を参照、前述の要領で、これ用の[*_config]設定をOV2640.cppとOV2640.hに追記、設定の上、ボードには[ESP32S3 Dev Module]を設定することになるでしょう(フラッシュメモリは8MBと余裕があるので同サイズ以下なら[Partition Scheme]は任意)。

遅まきながら、Arduino IDE 1.8.x系においてFreenove ESP32-S3カメラボードでサンプル以外のスケッチ(rtsp配信するほぼ本番用)を試してみたところ、config設定で微ハマったので追記。

ハマりどころは、Freenoveの[Sketch_07.2_As_VideoWebServer]にある[camera_pins.h]の[CAMERA_MODEL_ESP32S3_EYE]では、なぜか、これだけGPIO部分が、[Y2_GPIO_NUM]から始まり、[Y9_GPIO_NUM]の順となっている点。

他のconfigは、[Y9_GPIO_NUM]〜[Y2_GPIO_NUM]の順になっており、この順で参照して[OV2640.cpp]の[.pin_d7]〜[.pin_d0]の順に反映させないと無駄にハマります。

当該部分を間違えてもスケッチのコンパイルも完了してしまい、ボードにもアップロードできてしまう、指定したIPアドレスにpingすると通る、mDNSを盛り込んでいた場合も通る...

にも関わらず、シリアルモニタを眺めながら、端末からffplay rtsp://IP_ADDRESS/mjpeg/1などとしてアクセスするとrebootしたり、Camerra init errorになったり、Guru Meditation Error core 0 panic'ed (loadProhibited)とかになったりして当然、映像も表示されない...

こんなカオスにはさよならを。

また、ESP32-S3-WROOM-1開発ボードなら、PSRAMには、[OPI PSRAM]をセットします(WROVERボードでいけた[QSPI PSRAM]だとPSRAMがないとかなんとか...、ちゃんと違いを調べろ自分...)。

あとボード設定は、現時点では[ESP32S3 Dev Module]。

これだけでいけるはずですが、強いて言うなら、Flash Size:は、せっかくなのでボードが備える[8MB(64Mb)]、Partition Scheme:は、16Mや32M(や謎なRainMaker)でなければ、なんでも良いと思いますが、最も適していそうなのは[8M with spiffs(3MB APP/1.5MB SPIFFS)]。

それと関係あるか否か、それが何なのかさえ、わかりませんが、[.ledc_timer = LEDC_TIMER_1]は、[.ledc_timer = LEDC_TIMER_0]に、[.ledc_channel = LEDC_CHANNEL_1]は、[.ledc_channel = LEDC_CHANNEL_0]に変更しました。

ちなみにArduinoOTA.hを使った無線アップロードもできました。

あれ、WROVERボードよりESP32-S3-WROOM-1開発ボードの方が遅延が長い(レイテンシが大きい)...、RTSP(前者約1秒、後者約3秒)もRTP(前者約5秒、後者約10秒)も...なんで?どっかいじれば同程度くらいにはなるの...か?

と思ったら、[.frame_size]を[FRAMESIZE_UXGA]にしていたからでWROVERボード同様、[FRAMESIZE_SVGA]にしたら遅延も同じくらいになりました。

となるとフレームは、もっと小さくても十分だから、それがあれば、もう少し、遅延なくなるのか...と、[FRAMESIZE_QVGA]にしてみると小さく表示はされるものの、遅延とは無縁のようでレイテンシに変化はありませんでした。

お、opencvで試すと同じHVGAサイズでもRTSPストリームはほぼ遅延はないと言えるレベル。

また、ここまではcvlc(Debian上なのでより正確には、flatpakのVLCによるcvlc)でのRTP配信で遅延5〜6秒といった感じでしたが、opencvでRTPストリームを開いてみると体感で1秒ほどレイテンシが小さくなって遅延4秒くらいか...。

ん?少し画質が荒く見える?実用には耐える程度も実際荒いから?

ちなみに、このようにした後も、既存含むこれらの*_config設定値が不足しているエラーとなる場合、PSRAMがある前提で[.fb_count = 2]の後にカンマ(,)を足し、次行に順次[.fb_location = CAMERA_FB_IN_PSRAM,]、[.grab_mode = CAMERA_GRAB_LATEST,]、[.sccb_i2c_port = 1]を追記のこと。

必要なソフトウェア

ソフトウェアは主に次の通り。

- ffplay 4.3.6-0+deb11u1(要ffmpegインストール)

- VLC Media Player 3.0.18 Vetinari / buildbot@cncf-arm-3.flathub.org Jul 2 2023 20:21:19

- (mpv 0.32.0)

DebianにおけるVLCでのRTSP/RTP対応

尚、自身が使用しているDebian|Raspberry Pi OSにおいては、#981439、#982299、The VideoLAN Forums、askubuntu.comにあるようにliblivemediaがフリーではないコードを含むことからDebian GNU/Linuxプロジェクトのポリシーにマッチせず、苦渋の決断としてVLCにおけるRTSP/RTP配信あたりを無効にしているとのことで、ある時点から今に至るまでDebianのリポジトリからVLCをインストールするとこれら一部機能が利用できないようです。

単に当該ライブラリをnonfreeに収録すれば良いという単純な話ではなく、ましてフリーでオープンソースなVLC自体をnonfreeに収録することはできなかったってことなんでしょうね。

が、そんなDebian|Raspberry Pi OSでも何れも同様にsnapやflatpakからVLCをインストールすれば、RTP/RTSP配信及び関連設定もできるようになります。

VLCによるRTPストリーミング事前設定

RTPストリーミングを開始する前に[ツール]、[設定]から[ストリーム出力]、[出力手段]の[HOP上限値(TTL)](デフォルト-1)を2とか5とか10とか任意の正の値にしておく必要があるでしょう(そうしないとRTPでストリーミングできないかと思います)。

[設定]で[rtp]や[rtsp]で検索すると関連する項目が複数ありますが、今回の検証では、[HOP上限値(TTL)]以外の他の項目を変更する必要はありませんでした。

ちなみに、その中には[RTP/RTSP]の[RTPオーバーRTSP(TCP)の使用]という設定項目もあり、これにチェックを入れたとしても全てがそうなるわけではないのか、TCPでも可能にしてくれるのか、マルチキャスト/マルチクライアント対応もできました。

が、そう言えば、ここまで遅くなる?と思うほど、めちゃめちゃ遅延したことがありましたが、これを設定した時だったのかも...。

VLC(GUI)でRTSP/RTP配信・受信方法一例

その上で複数のデバイスやコマンド、VLCなど複数クライアントでストリーミングの同時再生において、ここで行なったRTP/RTSPストリーミングの配信・受信の概要は次の通り、

- ESP32+OV2640カメラボードRTSPアドレス・パスは、rtsp://IP_ADDRESS:8554/mjpeg/1

- マルチキャストとなるRTPアドレス・パスは、rtp://239.1.1.1:5004

- RTSP/RTP配信には、VLCを使用

- RTPストリームを受信・ストリーミング再生するのは、LAN内の任意のデバイス上の任意のプレイヤーffplay、mpv、配信デバイスとは別デバイス上の(Debianな人はsnapやflatpakの)VLCやcvlc等

マルチキャストのアドレス範囲は、224.0.0.0〜239.255.255.255、ポートのデフォルトは554な模様。

RTSPについては、デフォルトのポートは8554、付加するパスは/mjpeg/1がデフォルトというか例示されることも多い様子、今回使用のスケッチでは、ポートの変更は、スケッチ上で、パスの変更もsrc/CRtspSession.cpp内でできる模様。

ファイアウォールを使っている場合、当該ポートがオープンになっていることを確認、開いていなければ、開放する必要があります。

確認した環境においては、映像自体は動きも割と滑らかな一方、何れのアプリでも受信開始から5〜6秒でしょうか、そこそこの遅延がある関係で送信側・受信側の段取りの順番が重要なのか?と思わされることがありましたが、実際は、どちらが先でも問題ないようです。

さておき、RTP/RTSPストリーム送信側の設定。

- [メディア] => [ネットワークストリームを開く]([ストリーム]経由でも可)

- ネットワークURLとしてrtsp://IP_ADDRESS:8554/mjpeg/1などを入力しつつ、[再生]ではなく、プルダウンリストから[ストリーム再生]を選択・クリック

- 次画面で[次へ]をクリック

- 次画面のボタンのプルダウンから[RTP / MPEG Transport Stream]を選択・クリック、([次へ]ではなく、)[追加]ボタンをクリック

- [ポート]は受信側の指定ポートと同じ(VLCデフォルトの)[5004]そのままに[アドレス]欄に受信側と同じRTPマルチキャストアドレス[239.1.1.1]などと入れて[次へ]ボタンを選択・クリック

この時、プロトコルrtp://は不要、入れるとストリーミングできなくなるので要注意。 - [トランスコーディングを有効にする]にチェックを入れる場合は、[Video - H.264 + MP3(TS)]か[Video - MPEG-2 + MPGA(TS)]などTS/Transport Streamの選択肢を選択(するのが良さげ)、[次へ]ボタンをクリック

- 次画面の[その他のオプション]のON/OFFは何れでもOK、[ストリーム]ボタンをクリック

この時、最後の画面では、次のようなストリーム出力文字列が表示されるでしょう。

[:sout=#transcode{vcodec=h264,vb=800,acodec=mpga,ab=128,channels=2,samplerate=44100,scodec=none}:rtp{dst=239.1.1.1,port=5004,mux=ts} :no-sout-all :sout-keep]

結果、[Converting rtsp://...]というタイトルで三角コーンが表示されたVLCが起動した状態になります。

配信が開始されてもタイムは、00:00のまま、開始中は、動きを見せる場合もあるも、いざ開始するとインジケータも動きなしで再生ボタンが押された(停止ボタン表示)状態。

続いてRTPストリーム受信側。

- [メディア] => [ネットワークストリームを開く]

- ネットワークURLとして送信側と同じRTPマルチキャストアドレスとポートrtp://239.1.1.1:5004を指定、[再生]

- 端末でffplay rtp://239.1.1.1:5004

mpvやcvlcでも同様にパスを渡すだけでOK。

結果、同一LAN内の複数デバイス、同一デバイスでも複数のアプリで同じRTPパスにアクセスすることで同時に配信されるようになります。

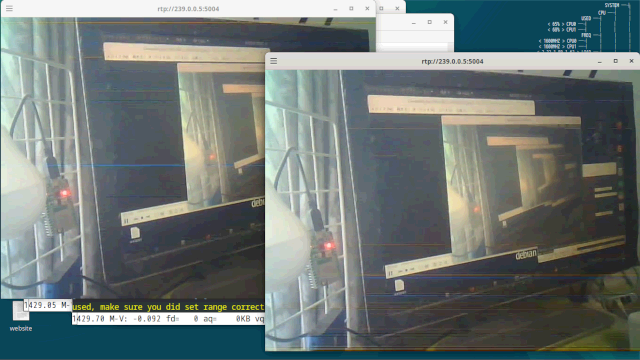

とりあえず、同時に4つのクライアントにRTPによるマルチキャスト配信してみました。

画像は、RTSP配信のESP32カメラボードのrtspパスをRTP配信しているRaspberry Pi 400パソコン/端末+ffplayとAndroidスマホ/VLC、それぞれでRTPストリームを受信中の様子。

更にdynabookでも端末を2つ起動し、それぞれffplayでrtpアドレスを渡して再生し、RTPストリームを受信している様子。

送信側としてはVLC、受信側としてはRTSP、RTP共にffplay、VLCのほか、MPVも使えましたが、MPVは他に比べ重く、遅延が大きい、MPlayer 1.4では何れも受信・再生できませんでした。

尚、PythonスクリプトでOpenCVを使ってcv2.VideoCapture()にrtsp://IP_ADDRESS:8554/mjpeg/1やrtp://IP_ADDRESS:5004などを指定、フレームを渡してcv2.imshow()してRTSPによる1デバイス1クライアントに対するストリーミングやRTPによるマルチクライアント・マルチキャストストリーミング再生をするとVLCやffplayより1〜2秒遅延時間が短かい(少ない)印象です。

cvlc(CLI)でRTSP/RTP配信・受信方法一例

実は、このマルチキャストビデオストリーム、自作したい防犯カメラはもとより、ドアホンでも使えないかと、ついてはCLI操作、ひいてはスクリプトにできればということでVLCのCLI版cvlc。

が、数秒の遅延があり、ドアホン用途には微妙ゆえ、代替策を模索中。

尤もリンク先のcvlcのより複雑な例などを見るにマルチキャストしつつ、特定デバイスにユニキャストなんてこともできるようなのでマルチキャスト受信デバイスは補助として遅延を容認、メインデバイスにユニキャストすれば、メインデバイスでの遅延は限りなく小さくなる?なら、全くナシでもないですが。

っていうかrtsp配信+ffplayなどで受信、それ以上にrtsp配信+opencvで受信だとほぼ遅延がないことからするとマルチキャストでこの程度の遅延は必然?ルーターの性能にもよる?

とは言え、どうもVLCがやってくれるRTPストリーミング部分をPythonなどのスクリプトでやっている情報はなさ気だったので成功体験の為、cvlcでお試し。

flatpak版VLCの場合、cvlcコマンドでのRTSP/RTP配信は、こんな感じ。

Debian/Raspberry Pi OS以外でディストロのリポジトリにあるVLCでいける場合は、flatpak run --command=cvlc org.videolan.VLC部分を単にcvlcに替えれば良いかと。

これをflatpak版VLCのcvlcでRTPストリームを受信すべくアクセスする場合、こんな感じ。

flatpak版ではなく、ディストロのリポジトリにあるVLCなら、前述の通り、単にcvlc rtp://239.255.12.42:5004のようにすればいけるかと。

もちろん、マルチキャストなので他デバイスでも他端末で同様にRTPパスを渡したffplayやmpvでも複数実行可能なマルチクライアントに対応。

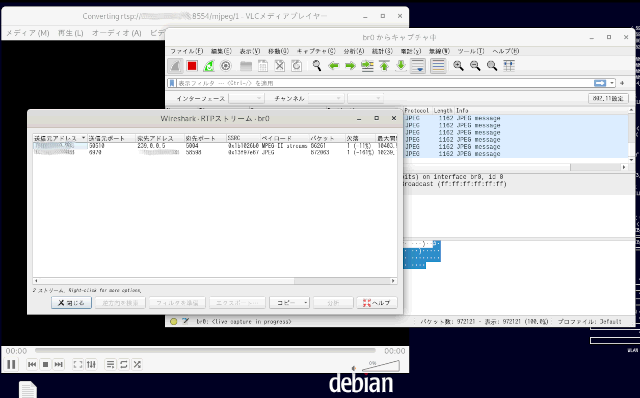

WiresharkでRTPストリームをキャプチャ

管理者権限でWiresharkを起動、LANにつながるネットワークインタフェースを選択、ダブルクリックするなりすると同ネットワークインタフェースを行き交うパケットが表示されます。

RTPについては、デフォルトのままだと全てキャプチャできないと思われるので[分析]、[有効化したプロトコル...]をクリック、ポップアップ表示される[Wireshark 有効にしたプロトコル]画面でアルファベット順になっているリストからRTPを辿り、適宜未チェックの項目にチェックを入れ[OK]で閉じます。

続いて[電話]、[RTP]、[RTPストリーム]をクリック、既にRTP配信中であれば、該当するリストが表示されるようになります。

もちろん、この時、Wiresharkを起動しているパソコン上(のVLCなど)でRTP配信します。

ローカルのネットワークインタフェースにおけるパケットのキャプチャなので。

すると、ここでは、RTP配信ホストとRTSP配信しているESP32ボードのIPアドレスとポートから相互にそれぞれパケットを送っている様子が見て取れます。

もちろん、Wiresharkなら、RTPストリームのみならず、RTSPストリームもキャプチャできます。

故障かな?と思ったら...

テストしてたら、VLCが起動しない!起動しなくなった!

そんな時は、GUIやCLIに関わらず、既に起動しているVLC(のプロセス)がないか確認してみましょう。

特に端末から実行して[Ctrl]+[c]で終了させたつもりが、意に反してプロセスは残っていたりするので要注意。

テストしてたら、VLCでRTP/RTSP配信や受信ができなくなった!

そんな場合、万人共通、起動と同じく、既存のVLC、cvlcプロセスがないか要確認。

もしかしてDebianやRaspberry Pi OSな人?もしかしてdebianやpiリポジトリのVLCも入れたまま?起動するVLCを間違えてるかも?

もしかしてcvlcコマンドそのまま使ってない?それdebianリポジトリのVLCのだよ?

ってあたりを確認してみると良いかも。

関連リンク

- ハードウェア

- ワンボードマイコン

- シングルボードコンピュータ

- Raspberry Pi

- Raspberry Pi導入検討に至った経緯

- Raspberry Piと関連パーツ購入を検討

- Raspberry Pi 2 Model B一式の選定と購入

- Raspberry Pi 2 Model B用OSの準備

- Raspbian Jessieの初期設定

- Raspbian Jessieで各種サーバを設定

- Raspberry Pi 2 Model B/Raspbianをサーバとして運用中

- ラズパイ用USBメモリ差替時LVMのinactiveでハマった話

- Raspbian Jessie 8からStretch 9へのアップグレード

- Raspbian Stretch 9からBuster 10へのアップグレード

- Raspberry Pi OS/Raspbian Buster 10からbullseye 11へのアップグレード

- Raspberry Pi OS BullseyeからBookwormへアップグレード

- Raspberry Piのホスト名変更とmDNS

- 自作スマートスピーカー用Raspberry Pi 3 B+を購入

- Raspberry Pi 3 Model B+とデスクトップPC周辺機器でパソコン化

- Raspberry Pi 3 Model B+とノートPC液晶他でパソコン化

- Raspberry Pi 3 Model B+とUSB HDDブート

- Raspberry Piの起動

- USB WiFiで復活したRaspberry Pi 3B+内蔵無線LANの謎

- ラズパイboot/reboot/shutdownボタン回路

- Raspberry Pi 3B+のハードウェア設定値がデフォルト値じゃない!?

- Raspberry Pi/スマホにWireGuardでVPN

- Raspberry Pi/スマホにSoftEther/OpenVPN互換でVPN

- Raspbianが勝手に喋りだした原因はOrca!?

- ラズパイ2 Bのディスクは3 B+で使えないの!?

- Raspberry PiでZoneMinderインストールとカメラ映像表示

- Raspberry Pi OS/Debian bullseyeにZoneMinderをインストール

- ラズパイ2BサーバのシステムディスクをUSBメモリからSSDに換装

- 謎が謎を呼ぶラズパイ2Bの挙動...と思いきや3B+でも同様

- HDMIケーブル接続のRaspberry Pi 2BとTVで動画視聴

- Raspberry Pi 400はサブパソコンを優に超越

- Raspberry Pi 400でできることは数知れず

- Raspberry Pi Imagerは時短にもなってすごい!

- SSHでPermission denied publickey 究極の対処法

- Raspberry Pi 400/arm64 Linux/Box86/Box64/WineでWindowsアプリ起動

- Raspberry Pi OSで壊れたPIXELとWineの復旧

- arm64 Raspberry Pi 400/Raspberry Pi OS/KVMで仮想化

- Raspberry Pi 400/Raspberry Pi OSにFlatpakをFlatpakからアプリをインストール

- Raspberry Pi 400/Raspberry Pi OSにsnapをsnapからアプリをインストール

- ラズパイで急に日本語入力不能にfcitx5-mozcからibus-kkcに変更・解決

- ラズパイ起動時デスクトップアイコン実行・フリーズ問題解決

- Raspberry Pi 400/USBメモリにAndroid 12L/LineageOS 19をインストール

- Raspberry Pi 400/USBメモリにAOSP 13/Android 13をインストール

- Raspberry Pi 400にWaydroidでLineageOS 18.xベースAndroid 11

- ラズパイ/Julius/Open JTalkでスマートスピーカーを自作

- Raspberry Piで見守り・防犯・監視カメラを自作

- ミニPC

- AMD Ryzen 7 8845HS搭載AOOSTAR GEM12 Pro MAXを買ってみた

- Windows 11/UbuntuインストーラLive USB作成とマルチブート

- AOOSTAR GEM12 Pro MAX搭載モニタ用Screen Control Software

- AMD Ryzen/RadeonチューニングアプリAMD Software

- CPU/GPU/iGPU/NPUを可視化する on Linux Ryzen 7 8845HS

- AIチャットボットCopilotをAMD Ryzen 7 8845HS AI PCで使う

- LM StudioでローカルAI on Linux/Windows Ryzen 7 8845HS

- Ollama/AlpacaとLLMでエッジAI on Linux Ryzen 7 8845HS

- ComfyUIやLocalAIでローカル生成AI on Linux Ryzen 7 8845HS

- Stable Diffusionでローカル生成AI on Linux Ryzen 7 8845HS

- 生成AIアプリAmuseをRyzen 7 8845HS/Hawk Pointで満喫

- AMD Ryzen AIソフトウェアのインストールから始まるRyzen AI

- PC

- 周辺機器

- モバイル

- フィーチャーフォン・ガラケー

- スマートフォン・タブレット

- スマホデビュー/Motorola moto g8 Power Lite

- Motorola moto g8 Power Lite用にスマホグッズ買ってみた

- Androidスマホの購入から使用まで

- Androidスマホやっておきたい初期設定

- Androidお気に入りのアプリ達

- Androidスマホバッテリーの節電設定と効果

- Miracast非対応Androidスマホmoto g8でAnyCastミラーリング成功

- スマホ乗り換え/Motorola moto g24

- Androidアプリストアの選択肢

- Android Studio

- SIMカード

- IoT/Internet of Things

- 電子工作・IoT超入門

- 電子工作・IoT入門1周年

- 電子工作・IoT入門から2年

- 電子工作・IoT入門から3年

- クラウドなしで快適スマートホームDIY

- スマート家電

- 電子工作・IoT用のパーツ

- IoT・電子工作購入品

- Arduino互換機ほかIoT・電子工作パーツ類の初購入

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入1

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入2

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入3

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入4

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入5

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入6

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入7

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入8

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入9

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入10

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入11

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入12

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入13

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入14

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入15

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入16

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入17

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入18

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入19

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入20

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入21

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入22

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入23

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入24

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入25

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入26

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入27

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入28

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入29

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入30

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入31

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入32

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入33

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入34

- Arduino互換機ほかIoT・電子工作パーツ類の追加購入35

- IoT・電子工作用はんだごてセットやマルチメータ等を購入

- IoT・電子工作購入品レビュー【100円ショップグッズ編】

- 電子部品調達先の変遷

- 部品取りパーツ類

- 工具・治具・加工機

- 電源・測定器

- Arduinoで電子工作・IoT

- Autodesk CircuitsでArduinoをシミュレーション

- Arduinoで『鳥さんトリあえず距離トリたい装置』を作る

- Arduino鳥獣よけ装置HC-SR501/LDR/砲弾型LED

- Arduino鳥獣よけ装置RCWL-0516/LDR/砲弾型LED

- Arduino鳥獣よけ装置RCWL-0516/LDR/WS2812B

- Arduinoで『温湿度計付きデジタル時計』を作る

- Arduino/LCD1602/RTCでSleep/表示・バックライトON/OFF SW付き時計を作る

- Arduinoで『タッチパネル式集約リモコン』を作る

- Pro Mini 5V版/Nano 5V版/Uno版ArduinoISPを作る

- 箱や扉を開けたら灯りが点く簡易回路を作る

- 暗くなると明かりが灯る常夜灯・街路灯原理回路を作る

- ICL8038 機能信号発生器DIYキットを組み立てる

- LM317 可変DC安定化電源DIYキットを組み立てる

- オシロスコープKyutech Arduino Scope

- RogerioBego/Oscilloscope-Arduino-Processing

- Saleae Logic互換 8ch 24MHz ロジックアナライザを使う

- aster94/DIY Logic Analyzer

- Arduinoでトランジスタ/リレー/モータドライバを使ってDCモータを動かす

- Arduinoでリレーを使ってAC100V家電を制御

- Arduinoで『玄関チャイム・ドアベル・呼び出しベル・呼び鈴』を作る

- Arduinoでレーザーとフォトレジスタによる光遮断検知回路を作る

- Arduinoで赤外線LEDとフォトトランジスタによる透過型センサ回路を作る

- Arduinoで『電圧計』を作る

- Arduinoで『回転計』を作る

- Arduinoで『距離計』を作る

- Arduinoでエアコンを制御

- Arduinoで『オルゴールっぽいもの』を作る

- Arduinoで音楽再生『FMmelody』

- Arduinoで音楽再生『PCMAudio』Arduino Playground

- Arduinoで音楽再生『PlayMelody』Arduino Tutorial

- Arduinoで『侵入検知・防犯ブザー』を作る

- Arduino+LED/DMM/オシロ/ロジアナでPWMを可視化

- Arduinoで『暗がり補助・誘導イルミネーション』を作る

- Arduinoで『自動ON/OFFタイマー付きLEDライト』を作る

- 『LEDテープライトによるデスク下照明』を作る

- Arduinoで『LEDテープライトによるベッド下照明』を作る

- ArduinoでRGB LEDテープライト自動制御デモ

- ArduinoでNeoPixel WS2812B LEDテープライト制御

- ProcessingとArduinoでLチカ

- Arduino側センサ値をProcessingでグラフ化デモ

- ArduinoとProcessingでアナログ・デジタル時計(日付・温度付き)

- ArduinoとProcessingでジャイロ・加速度センサMPU6050デモ

- ArduinoとProcessingで2人用テニスのデモ

- ArduinoとProcessingでグラフィックイコライザー風表示

- ArduinoとProcessingでRGB LED操作デモ

- ProcessingとWebカメラで動体検知・追跡デモ

- Processingでデジタル画像・動画認識ライブラリOpenCVを使う

- JavaScriptとArduinoでLチカ

- PythonとArduinoでLチカ

- RubyとArduinoでLチカ

- PerlとArduinoでLチカ

- CとArduinoでLチカ

- Arduinoとサーボモータで1軸ソーラートラッカーのデモ

- Arduinoとステッピングモータで100均のターンテーブルを回す

- しゃべるArduino音声合成・再生デモ

- Arduinoあれこれ

- ESP8266で電子工作・IoT

- ESP-01用『GPIO0/リセットボタン付き簡易回路』を作る

- ESP-01/12/ESP32でブラウザ(スマホ/タブレット/PC)越しLED制御

- ESP-01/12/ESP32でmDNS(常時IPではなくホスト名でアクセス)

- ESP32とTFT液晶で『温湿度計付き時計』を作る

- しゃべるESP-01/12/ESP32音声合成・再生デモ

- ESP8266を2つ使った『WiFi玄関チャイム・呼び出しベル』を作る

- ESP32とI2S対応マイクINMP441入力音源の保存と再生

- ESP32/アンプ付I2S対応DAC MAX98357A/スピーカーで音源再生

- ESP32/FIFO無OV7670/TFT1.8/ブラウザ/Linuxで映像表示デモ

- ESP32-CAM/deep sleep/PIRセンサー/ext0復帰で映像表示

- ESP32-CAM/deep sleep/PIR/タクトスイッチ/ext1復帰で映像表示

- OV2640カメラ付きESP32-WROVER-DEVボードで自作ライブカメラ

- ESP32-WROVER/OV2640/deep sleep/ボタン/ext0復帰で映像を表示

- ESP-01/12/ESP32で『スマートリモコン』を作る

- ESP-01/12/ESP32でSHARP AQUOS TVをWiFi操作

- ESP-01/12/ESP32でSHARP製エアコンをWiFi操作

- ESP-01/12/ESP32で東芝エアコン大清快をWiFi操作

- ESP-01/12/ESP32でリモコン付き空気清浄機をWiFi操作

- ESP-01/12/ESP32でリモコン付き扇風機をWiFi操作

- ESP-01/12/ESP32で『スマートコンセント』を作る

- ブラウザ版スマートホーム操作パネルを作る

- 無線電動ロールスクリーンを自作 ESP8266・ESP32/MQTT

- 自作無線電動ロールカーテン/ロールスクリーン

- WiFi/サーボで壁の照明スイッチをON/OFF 自作スマートスイッチ

- WiFi/サーボでWebカメラのパン/チルト ESP8266・ESP32/WebSocket

- WiFi/サーボでペンダントライトをON/OFF 自作スマートプルスイッチ

- 使用中のカーテンを無線電動化 ESP8266・ESP32/WebSocket

- 自作スマートカーテン/自動開閉タイマー付き無線電動カーテン

- 自作タッチレスセンサー式スイング開閉スマートごみ箱

- 自作スマートロック/色々な方法で施錠・解錠

- ESP32で温湿度センサ値をMQTT Publish

- ESP8266/ESP-WROOM-02/ESP32あれこれ

- Raspberry Piで電子工作・IoT

- Raspberry Pi/Julius/Open JTalkで『スマートスピーカー』を作る

- 主な基本機能

- Raspberry Pi 3 Model B+自作スマートスピーカーにラジオを追加

- Linuxパソコンに Julius/Open JTalkスマートスピーカー機能搭載

- ラズパイ400パソコンにJulius/OpenJTalkスマートスピーカー搭載

- ラズパイ3B+自作スマートスピーカーにニュース読み上げ機能追加

- Raspberry Pi 3 Model B+自作スマートスピーカーの自動起動設定

- ラズパイスマートスピーカーにUPnP/DLNAメディア再生機能を追加

- ラズベリーパイ 3 B+スマートスピーカーで定型アクションを実行

- ラズベリーパイ 3 B+自作スマートスピーカーにタイマー機能追加

- ラズベリーパイ 3 B+自作スマートスピーカーに音声メモ機能追加

- ラズパイ 3 B+自作スマートスピーカーに伝言メッセージ機能追加

- Julius / Open JTalkスマートスピーカーで OSS/ALSA/PulseAudio

- ラズパイ自作スマートスピーカーでYouTube音楽のストリーミング

- PyGTK/Gladeでラズパイ自作スマートスピーカー用操作パネル作成

- PyQt5/Qt Designerで自作スマートスピーカー用操作パネルを作成

- 突然音声が出なくなったスマートスピーカーのスピーカー音 復活

- Julius/Open JTalkスマートスピーカーからIPカメラの映像を表示

- 自作スマートスピーカーからビデオ会議や内線通話...etc.を開始

- 自作スマートスピーカー+Bluetoothスピーカーで聴取範囲を変更

- Raspberry Piで見守り・防犯・監視カメラシステムを自作

- ラズパイ/WebIOPi/RPI.GPIO/28BYJ-48でUSBカメラをパン・チルト

- ラズパイ/pywebview/RPI.GPIO/28BYJ-48でUSBカメラをパンチルト

- Raspberry Pi/Flask/RPI.GPIO/28BYJ-48でUSBカメラをパンチルト

- Raspberry Pi/Python/OpenCVでストリーム映像/画像の表示・保存

- IPカメラから映像配信通知を受信・動画/画像としてサーバに保存

- RTSP/RTPでマルチクライアント対応マルチキャストストリーミング

- Raspberry Pi/ESP32/MQTT/Node.js/PostgreSQLで温湿度環境モニタを自作

- Raspberry Piあれこれ

- 動画・ムービー

- 録音・再生・音源保存

- 音声合成・テキスト読み上げ

- 音声認識エンジン

- 動体検知Motion

- AI/人工知能

- AI開発環境

- DockerでTensorFlow/Keras開発環境を作る

- DockerでChainer開発環境を作る

- ChainerCV/YoloとWebカメラでリアルタイム物体検出デモ

- ChainerCV Object Detection/対象検出サンプルの実行

- ChainerRLとOpenAI Gymで強化学習シミュレーション

- DockerでPyTorch開発環境を作る

- 自然言語処理

- 自然言語処理ライブラリspaCy

- 形態素解析

- 構文解析/係り受け解析

- 自然言語処理モデル

- 自然言語処理モデルGPT

- 自然言語処理モデルGPT-3を使う

- OpenAI GPT-3のExamplesを試してみた

- OpenAI GPT-3のExamples/Chatを試してみた

- OpenAI GPT-3のExamples/Grammar correctionを試してみた

- OpenAI GPT-3のExamples/Natural language to OpenAI APIを試してみた

- OpenAI GPT-3のExamples/English to Frenchを試してみた

- OpenAI GPT-3のExamples/SQL translateを試してみた

- OpenAI GPT-3のExamples/Classificationを試してみた

- OpenAI GPT-3のExamples/Movie to Emojiを試してみた

- OpenAI GPT-3のExamples/Translate programming languagesを試してみた

- OpenAI GPT-3のExamples/Explain codeを試してみた

- OpenAI GPT-3のExamples/Factual answeringを試してみた

- OpenAI GPT-3のExamples/Product name generatorを試してみた

- OpenAI GPT-3のExamples/Python bug fixerを試してみた

- OpenAI GPT-3のExamples/JavaScript helper chatbotを試してみた

- OpenAI GPT-3のExamples/Science fiction book list makerを試してみた

- OpenAI GPT-3のExamples/Airport code extractorを試してみた

- OpenAI GPT-3のExamples/Extract contact informationを試してみた

- OpenAI GPT-3のExamples/Friend chatを試してみた

- OpenAI GPT-3のExamples/Write a Python docstringを試してみた

- OpenAI GPT-3のExamples/JavaScript one line functionを試してみた

- OpenAI GPT-3のExamples/Third-person converterを試してみた

- OpenAI GPT-3のExamples/VR fitness idea generatorを試してみた

- OpenAI GPT-3のExamples/Essay outlineを試してみた

- OpenAI GPT-3のExamples/Marv the sarcastic chat botを試してみた

- OpenAI GPT-3のExamples/Restaurant review creatorを試してみた

- OpenAI GPT-3のExamples/Interview questionsを試してみた

- OpenAI GPT-3のExamples/Q&Aを試してみた

- OpenAI GPT-3のExamples/Summarize for a 2nd graderを試してみた

- OpenAI GPT-3のExamples/Text to commandを試してみた

- OpenAI GPT-3のExamples/Natural language to Stripe APIを試してみた

- OpenAI GPT-3のExamples/Parse unstructured dataを試してみた

- OpenAI GPT-3のExamples/Python to natural languageを試してみた

- OpenAI GPT-3のExamples/Calculate Time Complexityを試してみた

- OpenAI GPT-3のExamples/Advanced tweet classifierを試してみた

- OpenAI GPT-3のExamples/Keywordsを試してみた

- OpenAI GPT-3のExamples/Ad from product descriptionを試してみた

- OpenAI GPT-3のExamples/TL;DR summarizationを試してみた

- OpenAI GPT-3のExamples/Spreadsheet generatorを試してみた

- OpenAI GPT-3のExamples/ML/AI language model tutorを試してみた

- OpenAI GPT-3のExamples/Tweet classifierを試してみた

- OpenAI GPT-3のExamples/SQL requestを試してみた

- OpenAI GPT-3のExamples/JavaScript to Pythonを試してみた

- OpenAI GPT-3のExamples/Mood to colorを試してみた

- OpenAI GPT-3のExamples/Analogy makerを試してみた

- OpenAI GPT-3のExamples/Micro horror story creatorを試してみた

- OpenAI GPT-3のExamples/Notes to summaryを試してみた

- OpenAI GPT-3のExamples/ESRB ratingを試してみた

- OpenAI GPT-3のExamples/Recipe generatorを試してみた

- OpenAI GPT-3のExamples/Turn by turn directionsを試してみた

- OpenAI GPT-3のExamples/Create study notesを試してみた

- コンピュータービジョン