ChainerCV/YoloとWebカメラでリアルタイム物体検出デモ

ChainerCV/YoloとWebカメラでリアルタイム物体検出デモ

ChainerCV/YoloとWebカメラでリアルタイム物体検出デモ

先日、DockerでChainerの開発環境を作りました。

生粋の文系人でニューラルネットワークも初めて、脳みそも退化し、とろけ始めているかもしれない自身は、一体、何から始めたらよいのか...、やはり、先人が示してくれているサンプルの実行が近道...なはず...。

というわけで早速、アドオンChainerMN/ChainerRL/ChainerCVからChainerCVを選択し、公式ドキュメントのサンプルを実行してみてみようと思ったら、エラーになり、他のサンプルを探して機械学習ChainerCVとYoloで『カメラ・動画対応!リアルタイム物体検出ソフト』を作るの『リアルタイム物体検出ソフト:Yolo_Chainer_Video.py』にたどり着きました。

(リンク先は、頑張っている理系を応援したいから配信しているとのこと...理系じゃないのにすみません...。)

ProcessingのVideoライブラリとProcessingのOpenCVライブラリで共にWebカメラによる動体検知を試していた自身にとってこれ以上ないタイムリーでありがたいサンプルです。

また、こちらを使わせて頂いたおかげで、後述のようにChainerCVの物体検出サンプルのエラーの原因もわかり、そちらのサンプルも実行できるに至りました。

Pythonは3系(Python 3.6.6)を使いますが、自動で入った模様の2系は、2.7.15rc1です。

ちなみに今回、検証に使っているパソコンのGPUは、Intel HD Graphics 510というオンボードのもので主流らしきNVIDIA製ではないのでCPUで動かしてみている一方、Intel CPU アクセラレータiDeepは、まだ、試していません。

DockerとDockerfile

少なくとも現時点では、UbuntuやCentOSならEE/Enterprise版も使えるようですが、DebianやFedoraはCE版のみ、RHLに触れたり、Fedoraを使っていたこともある自身もOSを乗り換えるほどの熱量はなく、DebianにCE版をインストールしました。

CE版のインストールは、OS、プラットフォームごとに詳述されているので戸惑うこともありませんでした。

Yolo_Chainer_Video.pyを実行してみると自身の環境に不足があり、Webカメラが認識できない旨のエラーに、また、[ModuleNotFoundError: No module named '_tkinter']というエラーにも遭遇しました。

結果、前者については、Docker上でWebカメラ(UVC)を使う方法に倣い、

- UVC対応USB機器を認識させるためのuvccaptureパッケージを追加

- GUIアプリQTにおいてX Window SystemのMIT-SHM/MIT SHared Memory拡張機能を無効にするらしき環境変数QT_X11_NO_MITSHMに1を設定

- docker run時に--deviceオプションとデバイスに対する特権を与える--privilegedオプションを指定

後者については、先日、開発環境として作成したDockerfileに

- Tcl/TkとPython3/Tkinter用のサウンド拡張python3-tkパッケージを追加

することで対処できました。

おかげで後者については、先に試したChainerCV Object Detectionのサンプルでエラーになった原因が、同様にpython3-tkパッケージの不足であることに気づき、そちらのサンプルも実行できるに至りました。

また、自身が何かしでかしたようでgitインストール時らしいのですが、これに依存してtzdataパッケージがインストールされる際に対話的にTimezoneを聞かれ、今までは6. Asia 78. Tokyoなどとしていたのですが、今回のDockerfileのdocker buildでは、なぜか、6(Asia)と入れたところでフリーズしたため、やむなく、

- 非対話形式にすべく、冒頭、FROM直後、apt installの前に(ここ重要)[ENV DEBIAN_FRONTEND=noninteractive]を追加

(ホストがDebian、仮想OSがUbuntuで、どっちに効くのか、これで良いのか迷ったものの、良いらしいです。)

こうすると起動時、日付時刻がUTCとなるため、気になる場合は、docker run時に[-v /etc/localtime:/etc/localtime:ro]を追加するとよいでしょう。

また、なぜか、docker build -tでイメージ名の命名ができず、docker tagでREPOSITORYとTAGを設定しました。

ちなみにmanページには、docker tag SOURCE_IMAGE[:TAG] TARGET_IMAGE[:TAG]とありましたが、noneだとカッコ付きでもエラーになるため、IMAGE IDでやってみたところできました。

apt installしているものの中には、今回のデモにあたっては不要なものもありますが、そのあたりは、よしなに。

Dockerコンテナ(仮想OS)を起動しますが、こられが何をしているのかについて必要であれば、冒頭のChainer開発環境のリンク先を参照ください。

parser.add_argument('--pretrained-model', default='voc0712')で使われているのは、Caffe/data/VOC712にある、これら画像を学習したものである模様です。

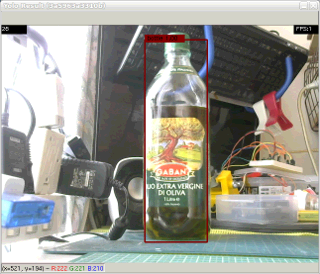

というわけでエクストラバージンオイルのガラス製のボトルを試してみることに。

デフォルトでよくて、カメラを使いたい場合は、引数に0を1つ渡すだけでよいとのことなので実行。

なんとWebカメラを向けたところ、100%(1.00)の確率でbottleだとバレ(認識され)ました。

ちなみに自分も映してみたら、100% personと認識されました(ホッ...)。

元リンク同様、ここでもCPUでの実行なので、ストップモーションどころの騒ぎではなく、タイムラグがすごいですが、見事な結果に満足です。

関連リンク

- AI/人工知能

- AI開発環境

- DockerでTensorFlow/Keras開発環境を作る

- DockerでChainer開発環境を作る

- ChainerCV/YoloとWebカメラでリアルタイム物体検出デモ

- ChainerCV Object Detection/対象検出サンプルの実行

- ChainerRLとOpenAI Gymで強化学習シミュレーション

- DockerでPyTorch開発環境を作る

- AIに触れてみる

- AMD Ryzen AIソフトウェアのインストールから始まるRyzen AI

- AMD Ryzen/RadeonチューニングアプリAMD Software

- CPU/GPU/iGPU/NPUを可視化する on Linux Ryzen 7 8845HS

- amd / RyzenAI-SW TutorialでAI学習

- 自然言語処理

- 自然言語処理ライブラリspaCy

- 形態素解析

- 構文解析/係り受け解析

- 自然言語処理モデル

- 自然言語処理モデルGPT

- 自然言語処理モデルGPT-3を使う

- OpenAI GPT-3のExamplesを試してみた

- OpenAI GPT-3のExamples/Chatを試してみた

- OpenAI GPT-3のExamples/Grammar correctionを試してみた

- OpenAI GPT-3のExamples/Natural language to OpenAI APIを試してみた

- OpenAI GPT-3のExamples/English to Frenchを試してみた

- OpenAI GPT-3のExamples/SQL translateを試してみた

- OpenAI GPT-3のExamples/Classificationを試してみた

- OpenAI GPT-3のExamples/Movie to Emojiを試してみた

- OpenAI GPT-3のExamples/Translate programming languagesを試してみた

- OpenAI GPT-3のExamples/Explain codeを試してみた

- OpenAI GPT-3のExamples/Factual answeringを試してみた

- OpenAI GPT-3のExamples/Product name generatorを試してみた

- OpenAI GPT-3のExamples/Python bug fixerを試してみた

- OpenAI GPT-3のExamples/JavaScript helper chatbotを試してみた

- OpenAI GPT-3のExamples/Science fiction book list makerを試してみた

- OpenAI GPT-3のExamples/Airport code extractorを試してみた

- OpenAI GPT-3のExamples/Extract contact informationを試してみた

- OpenAI GPT-3のExamples/Friend chatを試してみた

- OpenAI GPT-3のExamples/Write a Python docstringを試してみた

- OpenAI GPT-3のExamples/JavaScript one line functionを試してみた

- OpenAI GPT-3のExamples/Third-person converterを試してみた

- OpenAI GPT-3のExamples/VR fitness idea generatorを試してみた

- OpenAI GPT-3のExamples/Essay outlineを試してみた

- OpenAI GPT-3のExamples/Marv the sarcastic chat botを試してみた

- OpenAI GPT-3のExamples/Restaurant review creatorを試してみた

- OpenAI GPT-3のExamples/Interview questionsを試してみた

- OpenAI GPT-3のExamples/Q&Aを試してみた

- OpenAI GPT-3のExamples/Summarize for a 2nd graderを試してみた

- OpenAI GPT-3のExamples/Text to commandを試してみた

- OpenAI GPT-3のExamples/Natural language to Stripe APIを試してみた

- OpenAI GPT-3のExamples/Parse unstructured dataを試してみた

- OpenAI GPT-3のExamples/Python to natural languageを試してみた

- OpenAI GPT-3のExamples/Calculate Time Complexityを試してみた

- OpenAI GPT-3のExamples/Advanced tweet classifierを試してみた

- OpenAI GPT-3のExamples/Keywordsを試してみた

- OpenAI GPT-3のExamples/Ad from product descriptionを試してみた

- OpenAI GPT-3のExamples/TL;DR summarizationを試してみた

- OpenAI GPT-3のExamples/Spreadsheet generatorを試してみた

- OpenAI GPT-3のExamples/ML/AI language model tutorを試してみた

- OpenAI GPT-3のExamples/Tweet classifierを試してみた

- OpenAI GPT-3のExamples/SQL requestを試してみた

- OpenAI GPT-3のExamples/JavaScript to Pythonを試してみた

- OpenAI GPT-3のExamples/Mood to colorを試してみた

- OpenAI GPT-3のExamples/Analogy makerを試してみた

- OpenAI GPT-3のExamples/Micro horror story creatorを試してみた

- OpenAI GPT-3のExamples/Notes to summaryを試してみた

- OpenAI GPT-3のExamples/ESRB ratingを試してみた

- OpenAI GPT-3のExamples/Recipe generatorを試してみた

- OpenAI GPT-3のExamples/Turn by turn directionsを試してみた

- OpenAI GPT-3のExamples/Create study notesを試してみた

- コンピュータービジョン

- OCR/光学文字認識

- 物体認識・動体検知

- 画像認識

- 音声認識/Speech Synthesis/Speech to Text

- 音声合成/Text to Speech

- 電子工作・IoT・スマートデバイス例

- AIアシスタント・AIチャットボット

- AIチャットボットCopilotをAMD Ryzen 7 8845HS AI PCで使う

- LM StudioでローカルAI on Linux/Windows Ryzen 7 8845HS

- Ollama/AlpacaとLLMでエッジAI on Linux Ryzen 7 8845HS

- ComfyUIやLocalAIでローカル生成AI on Linux Ryzen 7 8845HS

- 音声・画像・映像...etc.生成AI